Creamos el mañana. Investigamos hoy

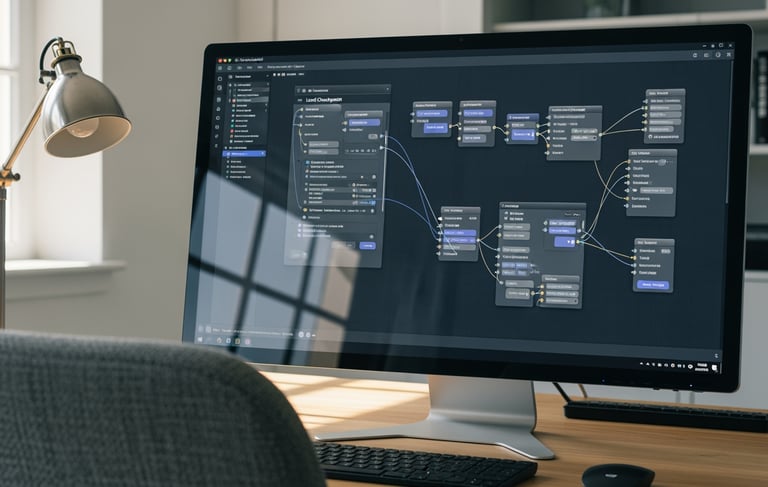

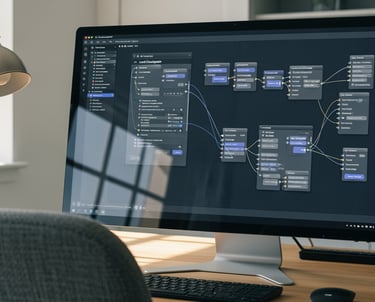

Revolucionando Nuestra Investigación: Por qué Adoptamos ComfyUI en el Laboratorio

En el vertiginoso campo de la Inteligencia Artificial generativa, las herramientas que utilizamos definen el límite de lo que podemos crear. Como laboratorio de vanguardia, nuestro objetivo no es solo seguir las tendencias, sino definirlas. Por eso, la integración de ComfyUI en nuestros flujos de trabajo no es una simple actualización; es una decisión estratégica para desbloquear un nuevo nivel de control, flexibilidad y reproducibilidad en nuestra investigación.

Mientras que otras interfaces de generación de imágenes ofrecen resultados rápidos, a menudo ocultan la complejidad subyacente. ComfyUI hace lo contrario: la expone

¿Qué es ComfyUI y por qué es Diferente?

A simple vista, ComfyUI es una interfaz gráfica (GUI) basada en nodos y grafos para interactuar con modelos de Stable Diffusion. En lugar de usar una serie de pestañas y controles deslizantes predefinidos, ComfyUI nos presenta un lienzo en blanco donde construimos nuestro proceso de generación.

Cada nodo representa una operación fundamental: cargar un modelo (checkpoint), definir un prompt, aplicar un sampler, decodificar con el VAE, etc. Conectamos estos nodos para crear un "flujo de trabajo" (workflow) visual.

Este enfoque modular es, precisamente, su mayor fortaleza para un entorno de laboratorio.

De la Caja de Música a la Caja de Herramientas

Integrar Suno en nuestro flujo de trabajo no tiene como objetivo reemplazar la composición humana, sino aumentar nuestras capacidades de investigación.

Nos permite estudiar la compleja relación entre el lenguaje semántico y la expresión musical. Nos proporciona un suministro infinito de datos de alta calidad para entrenar modelos de clasificación de género, análisis de sentimiento musical o separación de fuentes (voces vs. instrumentos).

En resumen, Suno es para nuestro equipo de audio lo que GPT-4 es para nuestro equipo de NLP o ComfyUI es para nuestro equipo de visión: una herramienta de vanguardia que nos permite construir más rápido y, al mismo tiempo, nos obliga a investigar más profundo.

Próximos pasos: Iniciaremos un proyecto para catalogar las capacidades y limitaciones de Suno en géneros específicos y comenzaremos a usarlo como base para la sonorización de nuestros prototipos visuales.

El Ecosistema Fragmentado: Por Qué la Explosión de Modelos de Imagen es la Mejor Noticia para Nuestro Laboratorio

Hace apenas unos años, la generación de imágenes coherentes a partir de texto era una curiosidad de investigación. Hoy, nos encontramos en medio de una explosión cámbrica: DALL-E 3 de OpenAI, Midjourney con su estética inigualable, la familia Imagen de Google, Adobe Firefly integrado en el flujo creativo y, por supuesto, el pilar de código abierto Stable Diffusion (de Stability AI y otros) con sus innumerables variantes.

Para el consumidor, esta avalancha de opciones puede parecer una simple "guerra de modelos" por ver quién genera la imagen más bonita o más realista.

Para un laboratorio de IA como el nuestro, es algo mucho más profundo. No es una guerra; es la creación de un ecosistema de especialización. Y nuestra estrategia no es elegir un ganador, sino aprovechar esta diversidad para investigar, construir y liderar.

Más Allá de la "Mejor" Imagen: Deconstruyendo el Panorama

Cada modelo que llega al mercado no es solo un competidor; es un conjunto diferente de decisiones filosóficas, arquitectónicas y de datos. Al analizarlos, no solo vemos "imágenes", vemos el ADN de la investigación de nuestros pares.

Así es como desglosamos el mercado y lo que aprendemos de cada segmento:

1. Los "Literalistas": DALL-E 3 e Imagen (Google)

Estos modelos destacan por su asombrosa capacidad para comprender y ejecutar prompts complejos y literales. Si les pides "un astronauta rojo montando un caballo en Marte bajo un cielo verde", es probable que te den exactamente eso, respetando la composición, el recuento de objetos y las relaciones espaciales.

Valor para el Laboratorio: Son nuestro campo de pruebas para la ingeniería de prompts avanzada y el estudio de la fusión entre LLMs y modelos de difusión. ¿Cómo traducen la semántica compleja en composición visual? Son el benchmark para la "obediencia" del modelo.

2. El "Esteta": Midjourney

Midjourney opera con una filosofía diferente. A menudo ignora partes de un prompt complejo, pero casi siempre produce un resultado artísticamente coherente y estéticamente superior. Tiene un "sello" visual, una opinión formada sobre lo que es una buena iluminación y composición.

Valor para el Laboratorio: Midjourney es un caso de estudio sobre el refuerzo estético y el fine-tuning. ¿Cómo se entrena un modelo para tener "buen gusto"? Analizar sus resultados nos da pistas sobre el prompt-expansion secreto y las técnicas de curación de datos que emplean para lograr ese nivel de calidad artística.

Motor Abierto": Stable Diffusion (SD 1.5, SDXL, etc.)

Este es, sin duda, el pilar de nuestra investigación aplicada. Al ser de código abierto, Stable Diffusion no es un producto final; es un motor fundamental. Es el chasis sobre el cual construimos todo lo demás.

Valor para el Laboratorio: Aquí es donde aplicamos herramientas como ComfyUI. Gracias a su naturaleza abierta, podemos:

Hacer Fine-Tuning: Entrenar nuestros propios modelos para tareas específicas (ej. imágenes médicas, planos arquitectónicos).

Extender Funcionalidad: Crear y probar LoRAs, ControlNets y flujos de trabajo de inpainting/outpainting que los modelos cerrados no permiten.

Optimizar: Investigar la cuantización, la poda (pruning) y la eficiencia de inferencia en nuestro propio hardware.

4. El "Especialista Corporativo": Adobe Firefly

Firefly representa la tercera vía: la integración ética y comercial. Entrenado exclusivamente con el set de datos de Adobe Stock (y contenido de dominio público), está diseñado para ser "comercialmente seguro", eludiendo los problemas de derechos de autor que plagan a otros modelos.

Valor para el Laboratorio: Firefly es nuestro principal caso de estudio sobre IA y ética de datos. ¿Qué tan buena puede ser la creatividad de un modelo cuando se restringe su conjunto de entrenamiento? Es la prueba de fuego para la viabilidad de la IA generativa en entornos corporativos y regulados.

Nuestra Estrategia: No Elegir, sino Sintetizar

Un músico no elige entre un piano, un violín o una batería; aprende a orquestarlos. Del mismo modo, nuestra estrategia de laboratorio no es apostar por un solo modelo.

Benchmarking Cruzado: Usamos la obediencia de DALL-E 3 y la estética de Midjourney como la vara para medir nuestros propios modelos entrenados sobre Stable Diffusion.

Hibridación de Flujos: En un flujo de trabajo avanzado (como los que diseñamos en ComfyUI), podemos usar un modelo para generar la estructura base, otro para refinar la estética y un ControlNet especializado para garantizar la pose.

Investigación de Arquitecturas: El "ruido" del mercado es, en realidad, una serie de experimentos públicos. Al estudiar las fortalezas y debilidades de cada lanzamiento, podemos inferir qué arquitecturas (ej. DiT, U-Net) y qué métodos de entrenamiento (ej. GANs vs. Difusión, RLHF estético) están ganando terreno.